在這個數位轉型浪潮席捲全球的時代,生成式AI以前所未有的力量,賦予企業創新與成長的無限可能。然而,伴隨而來的,是潛藏在技術光環下的法律風險,特別是第三方侵權訴訟的可能性,這已成為企業老闆與決策者不可忽視的嚴峻挑戰。您是否曾思考過,當AI工具生成內容時,可能在不經意間觸犯了他人的著作權、商標權,甚至侵害個人隱私?本篇文章將深入解析這些風險,並提供您老闆必讀的AI法律防火牆,助您在擁抱AI的同時,築起堅實的法律屏障。

我們將從多個面向剖析生成式AI應用所衍生的潛在法律糾紛,包括但不限於:

- AI生成內容與現有著作權、商標權的衝突點。

- 數據蒐集與訓練過程中的隱私權保護議題。

- AI輸出不實資訊所引發的名譽損害及連帶責任。

- 演算法偏見可能導致的歧視性後果與法律責任。

透過具體的案例分析與前瞻性的技術趨勢解析,我們將為您揭示風險所在,並提供一套系統性的風險評估與管理框架。我們將引導您辨識潛在的法律陷阱,並提供實操性建議,包括合約的審慎擬定、完善的授權機制、深入的內部培訓,以及必要的技術監控措施。我們的目標是讓您清晰掌握,如何將AI的創新活力轉化為企業成長的堅實動能,而非潛藏的法律負擔。

聯絡雲祥網路橡皮擦團隊,擦掉負面,擦亮品牌。

身為企業領導者,面對生成式AI帶來的創新機遇,您必須預先建構「老闆必讀的AI法律防火牆」,以防範潛在的第三方侵權訴訟風險。

- 審慎評估AI生成內容的智慧財產權風險,確保不侵犯現有著作權、商標權或專利權。

- 嚴格檢視AI訓練數據的來源與隱私合規性,避免個資外洩導致法律責任。

- 建立機制偵測並修正AI輸出內容中的不實資訊及演算法偏見,以防名譽損害或歧視性訴訟。

- 與AI服務供應商簽訂明確的合約,釐清責任歸屬並要求其提供相關授權證明。

- 定期對員工進行AI法律風險培訓,提升整體風險意識與應對能力。

- 導入技術監控工具,持續追蹤AI應用中的潛在侵權行為與違規情事。

- 針對AI生成內容,建立內部審核流程,確保其合法性與合規性後再予發布使用。

- 主動瞭解最新的AI法律案例與監管趨勢,適時調整風險管理策略。

- 與專業法律顧問合作,進行定期的AI法律風險評估與診斷。

Table of Contents

Toggle解讀生成式AI的第三方侵權風險:為何企業必須嚴肅以對?

生成式AI的隱憂:潛藏的法律訴訟地雷

生成式AI技術日新月異,為企業帶來前所未有的創新動力與效率提升。然而,在這股技術浪潮之下,潛藏著不容忽視的法律風險,特別是與第三方侵權相關的訴訟。企業若未審慎評估並採取適當的預防措施,可能面臨高額的賠償、商譽損害,甚至業務停擺的危機。理解並正視這些風險,是企業能夠安全、永續地應用生成式AI的基石。

第三方侵權風險主要源於生成式AI在訓練過程中使用了大量的數據,這些數據可能包含受版權保護的內容、商標、專利,甚至是個人隱私資訊。當AI模型基於這些數據生成新的內容時,若未能妥善處理,便可能無意間複製、改編或使用了受保護的元素,從而構成對原權利人權益的侵害。這不僅涉及單純的內容複製,更可能牽涉到更複雜的法律議題,例如演算法的歧視性偏見,或AI生成內容的不實資訊傳播所衍生的連帶責任。

以下幾點是企業在導入生成式AI時,必須嚴肅以對的第三方侵權風險核心:

- 智慧財產權侵害:AI生成內容可能直接或間接侵犯現有的著作權、商標權、專利權。例如,AI繪圖工具生成了與現有畫作高度相似的圖像;AI寫作助手生成的文章,其部分內容與受保護的文字素材雷同。

- 數據隱私與個資外洩:若訓練數據中包含個人身份資訊,AI模型在生成內容時,可能意外洩露或重構這些個資,違反相關數據保護法規,如GDPR或各國的個資保護法。

- 不實資訊與誹謗風險:生成式AI可能產出看似真實卻是虛假或誤導性的資訊,若企業應用此類資訊進行傳播,可能引發誹謗、名譽損害等訴訟。

- 技術偏見與歧視責任:訓練數據中的偏見可能被AI模型放大,導致生成帶有歧視性的內容。若企業應用此類內容,可能面臨反歧視法規的挑戰,並需承擔連帶責任。

- 第三方授權與合規性:企業使用的AI工具或平台,其訓練數據的來源是否合法、授權是否完備,亦是重要的風險點。若使用的工具侵犯了第三方權益,企業亦可能被追究責任。

為何企業必須嚴肅以對?原因在於,生成式AI的應用普及,使得侵權行為的發生門檻降低,擴大了潛在的受害者範圍,也使責任追溯更加複雜。法律實務上,法院對於新興科技的判斷會不斷演進,企業不能僅憑藉過往經驗來判斷風險。積極預防、全面評估,並建立有效的風險管理機制,不僅是規避法律責任的必要手段,更是確保企業能藉由AI技術實現可持續發展的關鍵策略。

避開AI侵權陷阱:企業導入生成式AI的法律風險控管實務指南

前置評估與合規框架的建立

在全面導入生成式AI解決方案之前,企業必須建立一套嚴謹的法律風險控管機制。這不僅是為了滿足現行法規要求,更是為了預防未來可能產生的潛在訴訟風險。首要之務在於進行全面的風險評估,深入瞭解所選用的生成式AI技術及其潛在的應用場景,分析其中可能涉及的智慧財產權、數據隱私、個人資料保護以及商業機密外洩等風險點。

為此,企業應建立以下關鍵的合規框架:

- 建立AI倫理與法律遵循委員會:由法務、技術、產品及營運等部門代表組成,負責審核AI應用開發與導入的法律風險,並制定相應的內部規範與處理流程。

- 進行詳盡的技術供應商盡職調查:仔細審視AI工具或平台的開發者、供應商的背景,瞭解其數據來源、模型訓練方式、以及是否有侵權爭議的歷史紀錄。確認其提供的服務是否符合數據保護法規(如GDPR、CCPA等)的要求。

- 制定明確的AI使用政策與操作指南:向所有可能接觸或使用生成式AI工具的員工提供清晰的指引,包含禁止用於生成侵權內容、傳播不實訊息、或非法爬取敏感數據等。

- 落實數據最小化與去識別化原則:在AI模型的訓練及運行過程中,盡可能減少個人資料的收集,並對必要收集的數據進行有效的去識別化處理,以降低數據洩露的風險。

- 建立內容審核與追溯機制:為AI生成內容建立一層次的審核關卡,並確保有足夠的日誌記錄,以便在發生爭議時能夠追溯內容的產生過程與相關數據。

唯有透過系統性的風險控管,企業才能在擁抱生成式AI帶來的創新機遇時,將第三方侵權訴訟的風險降至最低,確保企業的穩健發展。

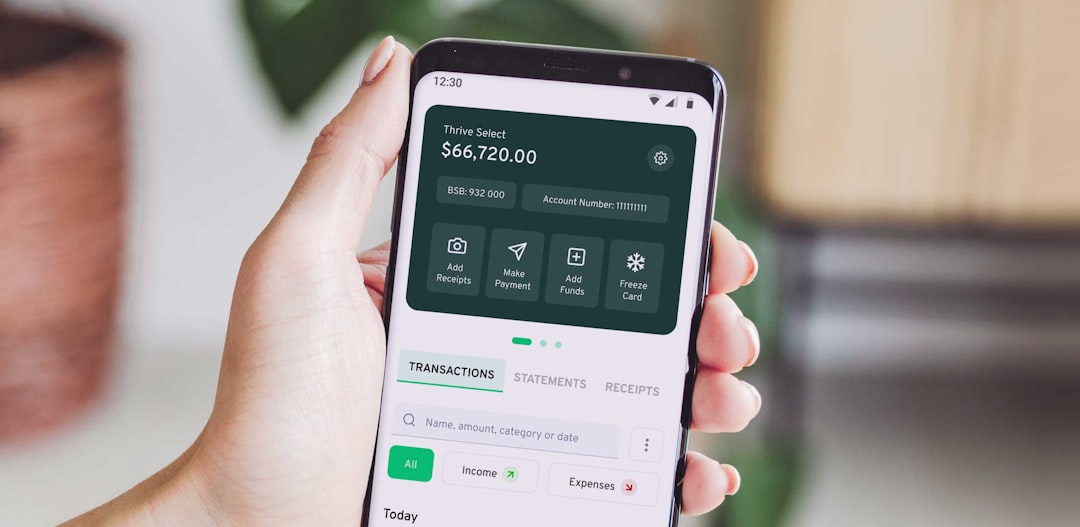

老闆必讀的AI法律防火牆. Photos provided by unsplash

從案例學趨吉避兇:生成式AI應用中的智慧財產權與數據隱私挑戰

智慧財產權的雷區:圖像、文字與程式碼的侵權風險

生成式AI的強大能力,使其能夠快速產出海量的圖像、文字、音樂甚至程式碼,這也帶來了嚴峻的智慧財產權(IP)挑戰。企業在導入生成式AI進行內容創作時,必須警惕潛在的第三方侵權風險。例如,AI模型在訓練過程中,可能使用了未經授權的受版權保護素材,導致其生成的內容與現有作品高度相似,進而引發版權侵權訴訟。這類風險不僅限於圖像,也包括文本(如書籍、文章)和程式碼。企業需要深入瞭解AI模型的訓練數據來源,並建立相應的審查機制,以降低因模型「學到」並複製受版權保護內容而面臨的法律風險。

幾個關鍵的風險點包括:

- 版權侵權:AI生成的圖像、文字或音樂,可能與現有受版權保護的作品構成實質性相似。

- 商標侵權:AI生成的標誌或名稱,可能與已註冊的商標雷同,導致商標權糾紛。

- 專利侵權:對於涉及特定技術或方法的AI生成內容,若其應用方式侵犯了現有專利,企業同樣可能面臨訴訟。

- 道德權侵犯:AI生成內容若損害了原創作者的聲譽或人格,也可能引發道德權爭議。

在實務操作中,建議企業在採用AI生成內容前,進行充分的權利檢索,並優先考慮使用來源清晰、授權合規的AI模型與數據集。此外,建立內部審核流程,由法務或專業人員對AI生成內容進行最終把關,也是不可或缺的環節。

數據隱私的暗礁:訓練數據與用戶資訊的合規性

生成式AI的發展離不開海量的數據,而這些數據的收集、儲存和使用,都可能觸及嚴格的數據隱私法規。企業在使用AI模型時,尤其需要關注其訓練數據的來源與合規性,以及在AI應用過程中,如何保護用戶的個人資訊。例如,若AI模型的訓練數據中包含了未經同意收集的個人敏感資訊,或者AI在運作過程中,無意間洩露了用戶的個人識別資訊,企業將面臨嚴重的數據洩露和隱私侵權責任。

數據隱私相關的挑戰主要體現在:

- 個人資訊洩露:AI模型可能在生成內容時,無意間洩露訓練數據中包含的個人資訊。

- 數據收集與使用不透明:企業未能充分告知用戶其數據被用於AI訓練或應用,違反了隱私權原則。

- 跨境數據傳輸的合規性:若AI應用涉及跨國數據傳輸,需遵守各國不同的數據保護法規(如GDPR、CCPA等)。

- 數據匿名化與去識別化不足:用於訓練的數據未被有效匿名化,仍可能存在識別特定個人的風險。

為規避這些風險,企業應當實施嚴格的數據治理政策,確保所有數據的收集、使用和儲存均符合相關法律法規的要求。這包括取得用戶的明確同意,對數據進行充分的匿名化和去識別化處理,並建立完善的數據安全防護措施。此外,對於第三方AI服務提供商,企業也應當進行嚴格的盡職調查,確保其數據處理行為符合法律規範,並在合約中明確數據隱私保護的責任歸屬。

| 風險類別 | 具體風險點 | 應對建議 |

|---|---|---|

| 智慧財產權 | 版權侵權:AI生成的圖像、文字或音樂,可能與現有受版權保護的作品構成實質性相似。 | 深入瞭解AI模型的訓練數據來源,建立相應的審查機制;進行充分的權利檢索,優先考慮使用來源清晰、授權合規的AI模型與數據集;建立內部審核流程。 |

| 智慧財產權 | 商標侵權:AI生成的標誌或名稱,可能與已註冊的商標雷同,導致商標權糾紛。 | 深入瞭解AI模型的訓練數據來源,建立相應的審查機制;進行充分的權利檢索,優先考慮使用來源清晰、授權合規的AI模型與數據集;建立內部審核流程。 |

| 智慧財產權 | 專利侵權:對於涉及特定技術或方法的AI生成內容,若其應用方式侵犯了現有專利,企業同樣可能面臨訴訟。 | 深入瞭解AI模型的訓練數據來源,建立相應的審查機制;進行充分的權利檢索,優先考慮使用來源清晰、授權合規的AI模型與數據集;建立內部審核流程。 |

| 智慧財產權 | 道德權侵犯:AI生成內容若損害了原創作者的聲譽或人格,也可能引發道德權爭議。 | 深入瞭解AI模型的訓練數據來源,建立相應的審查機制;進行充分的權利檢索,優先考慮使用來源清晰、授權合規的AI模型與數據集;建立內部審核流程。 |

| 數據隱私 | 個人資訊洩露:AI模型可能在生成內容時,無意間洩露訓練數據中包含的個人資訊。 | 實施嚴格的數據治理政策,確保所有數據的收集、使用和儲存均符合相關法律法規的要求,包括取得用戶的明確同意,對數據進行充分的匿名化和去識別化處理,並建立完善的數據安全防護措施。 |

| 數據隱私 | 數據收集與使用不透明:企業未能充分告知用戶其數據被用於AI訓練或應用,違反了隱私權原則。 | 實施嚴格的數據治理政策,確保所有數據的收集、使用和儲存均符合相關法律法規的要求,包括取得用戶的明確同意,對數據進行充分的匿名化和去識別化處理,並建立完善的數據安全防護措施。 |

| 數據隱私 | 跨境數據傳輸的合規性:若AI應用涉及跨國數據傳輸,需遵守各國不同的數據保護法規(如GDPR、CCPA等)。 | 實施嚴格的數據治理政策,確保所有數據的收集、使用和儲存均符合相關法律法規的要求,包括取得用戶的明確同意,對數據進行充分的匿名化和去識別化處理,並建立完善的數據安全防護措施。 |

| 數據隱私 | 數據匿名化與去識別化不足:用於訓練的數據未被有效匿名化,仍可能存在識別特定個人的風險。 | 實施嚴格的數據治理政策,確保所有數據的收集、使用和儲存均符合相關法律法規的要求,包括取得用戶的明確同意,對數據進行充分的匿名化和去識別化處理,並建立完善的數據安全防護措施。 |

| 數據隱私 | 第三方AI服務提供商的數據處理行為不合規 | 對第三方AI服務提供商進行嚴格的盡職調查,確保其數據處理行為符合法律規範,並在合約中明確數據隱私保護的責任歸屬。 |

AI法律風險管理關鍵:系統性框架與內部賦能的必要性

建構全面的AI法律風險管理系統

在生成式AI應用日益普及的當下,企業面臨的法律風險亦日趨複雜。僅僅關注單一的侵權行為已不足以構成有效的防護網。真正的關鍵在於建立一套系統性的AI法律風險管理框架,這套框架應貫穿AI應用的整個生命週期,從早期規劃、模型訓練、內容生成,到最終部署與監控,無一環節可被忽視。此框架的首要任務是風險識別與評估,這意味著企業需要積極主動地找出潛在的法律風險點,並對其發生的可能性及其潛在影響進行量化分析。這包括但不限於:

- 智慧財產權風險:評估訓練數據的授權合規性,以及生成內容可能構成的版權、商標、專利侵權。

- 數據隱私與安全風險:確保AI系統在數據收集、處理和儲存過程中符合《通用數據保護條例》(GDPR)或本地數據保護法規的要求,防止數據洩露或濫用。

- 不實資訊與誹謗風險:針對AI生成可能帶有誤導性、虛假或誹謗性質的內容,制定預防與修正機制。

- 演算法偏見與歧視風險:識別並緩解AI模型中可能存在的偏見,以避免產生歧視性結果,進而引發法律訴訟。

- 合約與第三方責任風險:審慎審核與AI服務供應商、數據提供商的合約條款,明確責任歸屬,並評估潛在的連帶法律責任。

一旦風險被識別,風險應對策略的制定與實施便是下一個重要環節。這包括風險規避(如避免使用高風險的數據源)、風險轉移(如購買相關保險)、風險降低(如實施嚴格的內容審核機制)以及風險接受(對低影響、低概率的風險)。因此,系統性的風險管理不僅是技術問題,更是企業治理層面必須高度重視的戰略性議題。透過結構化的風險管理流程,企業能夠更有條理地應對AI帶來的挑戰,確保業務的合規與可持續發展。對外,需關注相關法律法規的更新;對內,則需要強化組織的風險意識和應對能力。

內部賦能:提升員工AI法律風險意識與能力

除了建立完善的系統性框架,組織內部的賦能更是AI法律風險防範不可或缺的一環。再嚴謹的制度,若缺乏執行者的認知與能力,終將淪為紙上談兵。因此,企業必須積極投入資源,系統性地提升員工在AI法律風險方面的意識與專業能力。這意味著需要針對不同層級、不同崗位的員工,設計具體且具有針對性的培訓計畫。例如:

- 高階管理者與決策者:應聚焦於AI應用對企業戰略、聲譽及潛在法律責任的宏觀影響,以及風險管理的戰略佈局。

- 技術研發與產品團隊:需深入瞭解AI模型訓練、數據使用、內容生成等環節的法律風險,掌握合規設計(Privacy by Design)與安全設計(Security by Design)的原則。

- 內容創作者與營運人員:應學習辨識AI生成內容中的潛在侵權與不實資訊,並掌握正確的內容審核與標示規範。

- 法務與合規部門:則需持續關注AI技術與法律的發展,將其轉化為企業內部的政策與指導方針,並能提供即時的法律諮詢與風險評估。

培訓內容可以涵蓋最新的AI侵權訴訟案例、著作權法、商標法、數據隱私法規的關鍵條款、以及倫理準則等。透過多元化的培訓形式,如線上課程、線下研討會、案例分析工作坊、模擬演練等,確保培訓的有效性與趣味性。此外,建立內部AI法律風險知識庫與諮詢管道,鼓勵員工主動學習與交流,也能有效促進風險意識的普及。持續的教育與溝通是關鍵,這能確保AI法律風險的防範成為組織文化的一部分,而非僅僅是法務部門的責任。當每一位員工都能理解並實踐AI法律風險的相關規範,企業才能真正築起一道堅實的第三方侵權訴訟防火牆。

老闆必讀的AI法律防火牆結論

生成式AI的應用浪潮勢不可擋,為企業的創新與發展注入了強勁的動力。然而,在這場技術革命中,潛藏的第三方侵權訴訟風險如同隱形的礁石,可能讓企業的航行遭遇顛簸。本文深入剖析了生成式AI在智慧財產權、數據隱私、不實資訊傳播及演算法偏見等多方面可能引發的法律挑戰,並強調了建立系統性風險管理框架與提升內部員工風險意識的關鍵性。老闆必讀的AI法律防火牆並非遙不可及,而是透過對風險的前瞻性辨識、嚴謹的合規框架建立、全方位的案例學習,以及持續的內部賦能,得以逐步建構與鞏固。

唯有如此,企業才能在擁抱AI帶來的無限機遇時,有效規避潛在的法律陷阱,將AI從潛在的負擔轉化為企業持續成長的堅實助推器。確保AI的應用不僅合乎法規,更能為企業的長遠發展奠定穩健的基石。這不僅是對法律風險的迴避,更是對企業品牌聲譽和永續經營的長遠投資。

您是否已準備好為您的企業築起一道堅實的AI法律防火牆?現在就採取行動,讓您的企業在AI時代乘風破浪,安全前行!

聯絡【雲祥網路橡皮擦團隊】,為您的品牌擦掉負面,擦亮品牌。立即點擊連結瞭解更多:https://line.me/R/ti/p/%40dxr8765z

老闆必讀的AI法律防火牆 常見問題快速FAQ

什麼是生成式AI的第三方侵權風險?

第三方侵權風險指的是,企業在導入生成式AI應用時,AI生成的內容可能無意間侵害了第三方的著作權、商標權、專利權,或違反數據隱私規定,進而引發法律訴訟。

企業導入生成式AI時,最常見的智慧財產權風險有哪些?

最常見的智慧財產權風險包括AI生成內容與現有受版權保護的作品實質性相似(版權侵權),或是生成的標誌、名稱與現有商標雷同(商標侵權)。

數據隱私是生成式AI應用中的一個重要議題,企業該如何應對?

企業應確保AI模型的訓練數據來源合規,並在AI應用過程中保護用戶個人資訊,包括取得明確同意、進行數據匿名化處理,以及建立完善的數據安全防護措施。

為什麼建立系統性的AI法律風險管理框架對企業很重要?

系統性風險管理框架能幫助企業全面識別、評估並應對AI應用中的各種法律風險,包括智慧財產權、數據隱私、不實資訊及演算法偏見等,以降低訴訟發生的可能性。

除了系統性框架,企業還需要做什麼來防範AI法律風險?

企業需要透過系統性地提升員工對AI法律風險的意識與能力,設計有針對性的培訓計畫,並建立內部知識庫與諮詢管道,將風險防範融入企業文化。

AI生成的不實資訊會對企業造成哪些法律風險?

AI生成的不實資訊若被企業傳播,可能導致名譽損害、誹謗訴訟,並可能需要承擔連帶責任。

演算法偏見可能帶來哪些法律責任?

演算法偏見可能導致生成帶有歧視性的內容,若企業應用此類內容,可能面臨違反反歧視法規的法律責任。