隨著人工智慧(AI)以前所未有的速度滲透到商業運營的各個層面,領導者正站在一個關鍵的十字路口。我們迎來了一個由演算法驅動的決策時代,AI能提供強大數據分析、預測模型,甚至提出建議。然而,在這股智能浪潮中,一個核心的領導原則越發顯著:決策責任的不可外包性。

這意味著,即便AI工具能夠極大地輔助甚至優化決策過程,最終的權衡、判斷與後果承擔,依然牢牢地落在領導者肩上。AI是強大的協作者,而非責任的轉嫁者。領導者必須深入理解AI的運作機制,識別潛在的偏見與風險,並始終保持對最終決策結果的終極掌控力與責任感。這不僅是對企業、員工、客戶負責,更是對AI技術倫理使用的基本要求。真正的領導力,在AI時代並非削弱,而是昇華為一種更深層次的智慧與責任的結合。

為了在AI驅動的環境中有效駕馭複雜的決策,我們建議領導者採取以下關鍵步驟:

- 建立健全的AI治理框架:明確AI使用的界線、倫理準則、數據隱私保護和風險評估機制。

- 培養團隊的AI素養與批判性思維:確保團隊成員理解AI的能力與限制,並能對AI提供的資訊進行批判性審查。

- 堅持以人為本的價值觀:確保AI的應用符合企業的核心價值觀和道德標準,尤其是在涉及公平性、透明度和人類福祉的決策上。

- 持續學習與適應:AI技術日新月異,領導者需要不斷更新知識,理解最新的AI發展趨勢及其對決策的影響。

聯絡雲祥網路橡皮擦團隊 擦掉負面,擦亮品牌

在AI時代,領導者必須深刻理解並實踐「決策責任的不可外包性」,確保技術輔助不取代最終的判斷與擔責。

- 將AI視為強大的輔助工具,而非決策的代理者,始終保留最終的決策權與判斷力。

- 深入瞭解AI的運作機制、潛在偏見與風險,纔能有效辨識AI建議的適用性與侷限。

- 建立清晰的AI治理框架,明確倫理準則與責任歸屬,確保AI應用符合組織價值觀。

- 積極培養團隊的AI素養及批判性思維,提升對AI資訊的審慎評估能力。

- 堅守以人為本的原則,確保AI決策的公平性、透明度,並以人類福祉為核心考量。

Table of Contents

ToggleAI浪潮下的決策權核心:為何領導者的責任不可外包?

智能輔助下的權責界定

在人工智慧(AI)技術飛速發展並深入各行各業的當下,企業領導者正面臨前所未有的決策挑戰。AI演算法能夠處理龐大的數據、識別複雜的模式,並在極短的時間內提供極具價值的洞察與建議,彷彿為決策過程注入了超凡的智慧。然而,這種強大的輔助能力,卻也引發了一個核心問題:當AI成為決策的重要助力時,領導者是否能將最終的決策責任外包給機器? 答案是明確且不容置疑的:決策責任的不可外包性,是AI時代領導者必須堅守的鐵律。

AI系統,無論其多麼先進,本質上是基於既有數據和特定演算法運作的工具。它們的決策邏輯、優化目標,乃至於可能存在的偏見,都源於其設計者和訓練數據。當AI生成決策建議時,它並非真正意義上的「理解」或「判斷」;它是在模擬、預測和優化。因此,即使AI能夠提供精準的數據分析和高度擬合的預測模型,其產生的結果也僅僅是「輔助」性質的建議。領導者作為組織的掌舵者,其職責在於運用這些輔助資訊,結合對組織願景、價值觀、倫理原則以及複雜情境的綜合考量,做出最終的、具有約束力的決策。

試想,若將最終決策權交予AI,一旦出現偏差、失誤,甚至倫理上的爭議,責任歸屬將變得模糊不清。是AI本身有問題?是數據有偏頗?是演算法不夠完善?抑或是使用者理解和應用AI建議不當?這些問題都指向了人類在決策鏈條中的關鍵節點——領導者——的缺位。 領導者的角色不僅在於效率和產出的最大化,更在於對結果的擔責,對組織的引領,以及對社會倫理的維護。將這份核心職責外包,不僅是對領導者身份的背離,更是對組織整體健康發展的潛在威脅。因此,理解AI的角色是輔助而非代理,並在此基礎上確立領導者不可動搖的最終決策權與責任, 是所有領導者在AI時代必須深刻體認的首要原則。

- AI在決策過程中扮演「輔助」角色,提供數據分析與建議。

- 領導者必須基於AI的輔助,結合自身判斷做出最終決策。

- 決策責任的核心在於領導者,無法外包給AI系統。

- 將決策責任外包給AI,會模糊責任歸屬,並可能引發倫理爭議。

- 領導者需理解AI的侷限性,並承擔起AI輔助決策的最終後果。

建構AI協作決策框架:領導者應具備的五大實踐要點

確立AI輔助與領導者決策界線

在AI日益滲透決策流程的今日,領導者面臨的挑戰是如何有效地區分AI的角色——是作為強大的輔助工具,抑或可能演變成決策的代理者。明確界定AI在決策過程中的邊界至關重要。AI能夠處理海量數據、識別複雜模式並提供預測性洞見,這些都極大地增強了決策的廣度和深度。然而,AI本身並不具備價值判斷、倫理考量及對結果承擔責任的能力。因此,領導者必須時刻警惕,確保AI的建議始終服務於人類的最終判斷,而非取代之。這意味著,即使AI的分析結果看似無懈可擊,領導者仍需進行批判性審視,結合自身經驗、對情境的理解以及企業的核心價值觀,做出最終決定。

培養AI素養與批判性思維

為了有效協作並審慎決策,領導者及其團隊必須具備相應的AI素養。這不僅包括理解AI的基本原理、不同演算法的運作方式及其潛在侷限,更關鍵的是培養批判性思維能力,以質疑和評估AI輸出的資訊。領導者應鼓勵團隊成員深入探究AI模型的決策邏輯,理解其預設的偏見或數據盲點。以下是培養AI協作決策能力的關鍵實踐:

- 提升AI知識水平: 領導者應主動學習AI技術的發展趨勢、應用範疇及其倫理風險,並鼓勵團隊參與相關培訓。

- 鼓勵質疑與探討: 建立開放的溝通環境,讓團隊成員能夠對AI生成的建議提出質疑,並進行深入討論,找出潛在的不足之處。

- 理解數據的影響: 認識到AI決策的品質高度依賴於輸入數據的品質與完整性,並關注數據採集、處理和使用過程中的潛在偏見。

- 情境化應用AI: 學習如何在特定的業務情境下,最有效地利用AI工具,並明白哪些決策環節需要人類的智慧和判斷。

- 持續學習與調適: AI技術日新月異,領導者需要保持敏銳的洞察力,不斷學習新的AI應用,並根據實際情況調整協作決策的模式。

建立健全的AI治理與倫理框架

有效的AI協作決策離不開一個健全的治理框架。領導者有責任確保AI的應用符合企業的倫理標準和法律法規。這包括制定明確的AI使用政策、數據隱私保護措施,以及異常事件處理機制。一個完善的治理框架能夠為AI的部署和運行提供指導,降低潛在風險,並確保決策過程的透明度和可追溯性。領導者應積極推動組織內部建立一套能夠識別、評估和緩解AI相關風險的機制,例如:

- 明確AI決策的責任歸屬: 即使AI提供建議,最終的決策者和責任承擔者必須清晰界定。

- 建立AI審計機制: 定期對AI系統的性能、準確性和公平性進行審計,確保其符合預期。

- 制定應急預案: 針對AI系統可能出現的故障、誤判或倫理爭議,預先制定應急響應計劃。

- 確保數據倫理: 嚴格遵守數據隱私法規,確保數據的合法獲取、安全儲存和負責任使用。

- 推動透明化溝通: 在組織內部就AI的應用範圍、能力和限制進行透明化的溝通,建立信任。

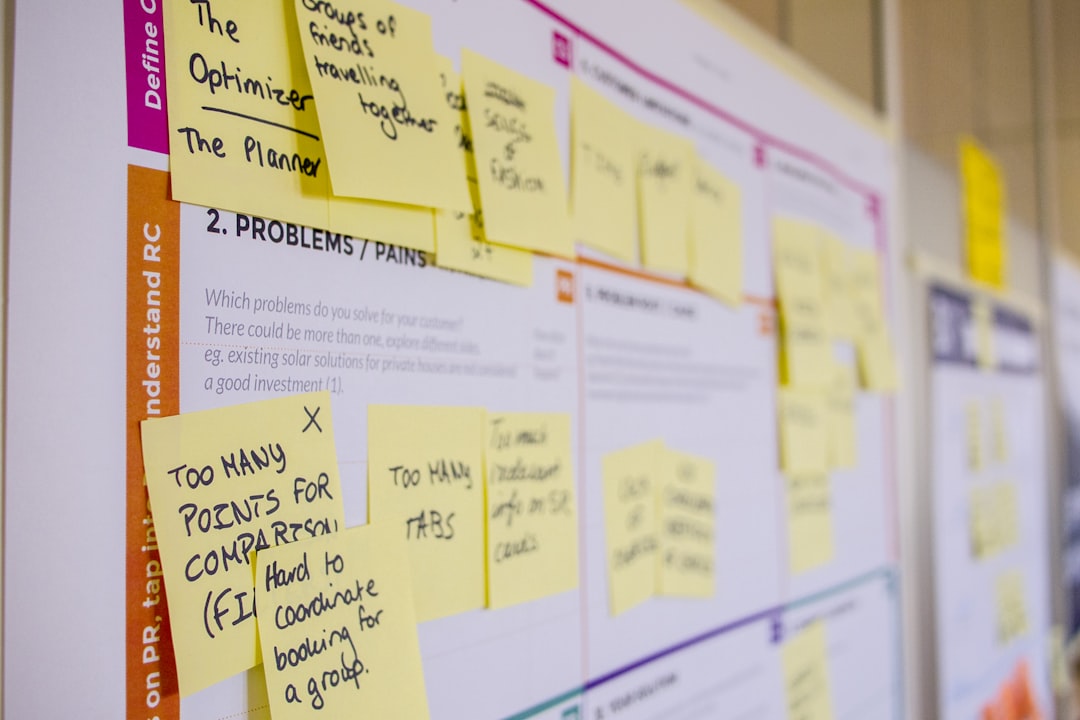

決策責任的不可外包性. Photos provided by unsplash

超越演算法的智慧:AI輔助決策中的人性判斷與倫理界線

AI的侷限性:演算法背後的價值觀與偏見

儘管AI在數據分析和模式識別方面展現出驚人的能力,但其決策本質上仍是基於歷史數據和預設演算法。這意味著AI可能無意識地複製甚至放大數據中存在的偏見,並難以捕捉複雜的人類情境、道德灰色地帶或新興的倫理考量。例如,在招聘或信貸審批中,若訓練數據存在性別或種族歧視,AI系統便可能延續這些不公。

領導者必須理解:

- AI的訓練數據決定了其「世界觀」: 數據的質量、代表性和潛在偏見是影響AI決策的關鍵因素。

- 演算法無法取代價值判斷: 許多決策涉及社會公平、人權、長期可持續性等難以量化的價值觀,這是AI目前無法獨立衡量的。

- 不可預見的後果: AI的決策路徑可能極其複雜,有時連開發者也難以完全解釋其產生的具體原因,這增加了追溯責任的難度。

劃定倫理界線:在AI時代堅守領導者的道德羅盤

AI的普及化不僅挑戰了決策的執行方式,更嚴峻地考驗著領導者的道德底線。當AI能夠提供看似客觀、高效的解決方案時,領導者面臨的誘惑是如何將艱難的倫理抉擇「外包」給機器,從而規避個人責任。然而,這種做法不僅違背了領導力的本質,也可能引發嚴重的倫理危機與信任危機。

領導者應採取的關鍵步驟:

- 建立清晰的AI倫理準則: 制定適用於AI應用和數據使用的明確倫理規範,並確保所有員工理解並遵守。

- 優先考量人權與公平性: 在AI設計和部署的各個階段,都要將人權、公平和無歧視原則置於首位。

- 定期進行倫理審計: 對AI系統的運作進行定期的倫理審查,特別關注其對弱勢群體可能產生的影響。

- 推動AI決策的透明化與可解釋性: 雖然完全的可解釋性難以實現,但應盡力確保AI決策過程的透明度,以便於監督和問責。

我們必須銘記: AI是工具,而非道德仲裁者。領導者必須保持警惕,確保AI的應用始終服務於人類的福祉,而不是成為逃避責任的藉口。在AI輔助決策的過程中,人性的判斷、同理心和長遠的倫理考量,是任何演算法都無法取代的寶貴資產。

| AI的侷限性 | 領導者必須理解 | 劃定倫理界線 | 領導者應採取的關鍵步驟 | 我們必須銘記 |

|---|---|---|---|---|

| 儘管AI在數據分析和模式識別方面展現出驚人的能力,但其決策本質上仍是基於歷史數據和預設演算法。這意味著AI可能無意識地複製甚至放大數據中存在的偏見,並難以捕捉複雜的人類情境、道德灰色地帶或新興的倫理考量。例如,在招聘或信貸審批中,若訓練數據存在性別或種族歧視,AI系統便可能延續這些不公。 | AI的訓練數據決定了其「世界觀」:數據的質量、代表性和潛在偏見是影響AI決策的關鍵因素。 演算法無法取代價值判斷:許多決策涉及社會公平、人權、長期可持續性等難以量化的價值觀,這是AI目前無法獨立衡量的。 不可預見的後果:AI的決策路徑可能極其複雜,有時連開發者也難以完全解釋其產生的具體原因,這增加了追溯責任的難度。 |

AI的普及化不僅挑戰了決策的執行方式,更嚴峻地考驗著領導者的道德底線。當AI能夠提供看似客觀、高效的解決方案時,領導者面臨的誘惑是如何將艱難的倫理抉擇「外包」給機器,從而規避個人責任。然而,這種做法不僅違背了領導力的本質,也可能引發嚴重的倫理危機與信任危機。 | 建立清晰的AI倫理準則:制定適用於AI應用和數據使用的明確倫理規範,並確保所有員工理解並遵守。 優先考量人權與公平性:在AI設計和部署的各個階段,都要將人權、公平和無歧視原則置於首位。 定期進行倫理審計:對AI系統的運作進行定期的倫理審查,特別關注其對弱勢群體可能產生的影響。 推動AI決策的透明化與可解釋性:雖然完全的可解釋性難以實現,但應盡力確保AI決策過程的透明度,以便於監督和問責。 |

AI是工具,而非道德仲裁者。領導者必須保持警惕,確保AI的應用始終服務於人類的福祉,而不是成為逃避責任的藉口。在AI輔助決策的過程中,人性的判斷、同理心和長遠的倫理考量,是任何演算法都無法取代的寶貴資產。 |

洞悉AI決策迷霧:區分輔助與代理,確立領導者的最終把關角色

輔助決策 vs. 代理決策:釐清AI角色的界線

在AI日益滲透企業決策過程的今日,領導者必須深刻理解AI在決策鏈中所扮演的角色,區分其是作為「決策輔助工具」還是「決策代理者」。AI輔助決策,意味著AI系統提供數據分析、風險評估、模式識別等洞見,供領導者參考,但最終的判斷與決策權仍牢牢掌握在人類手中。反之,若將AI視為決策代理者,則將決策權讓渡給演算法,這不僅模糊了責任歸屬,更可能導致決策失誤時的嚴重後果難以追究。領導者必須警惕將關鍵決策完全交由AI代勞的誘惑,這無疑是放棄了領導者的核心職責。

- AI輔助決策的關鍵特徵:提供資訊、分析趨勢、識別風險、優化選項,但非最終拍板。

- AI代理決策的潛在風險:責任模糊、演算法偏見的放大、失去對決策過程的掌控、以及潛在的道德困境。

領導者的最終把關角色:系統性風險辨識與人本價值堅守

確立AI在決策體系中的適當位置,意味著領導者必須回歸其「最終把關者」的角色。這不僅是技術層面的操作,更是戰略與倫理層面的責任。領導者需要具備的能力包括:

- 系統性風險辨識:深入理解AI模型的工作原理,預見其潛在的失效模式、數據偏差、以及非預期的後果。這需要跨領域的知識,結合技術理解與業務洞察。

- 倫理界線的劃定:在AI建議的基礎上,領導者必須引入人性化的價值判斷和道德考量。例如,即使AI推薦了某項可能帶來最大利潤的策略,但若該策略涉及剝削或不公平,領導者仍應基於倫理原則加以否決。

- 建立問責機制:為AI輔助決策過程設計清晰的問責流程。當決策出現問題時,必須能夠追溯到決策環節中的人類參與者,而非簡單歸咎於AI系統本身。

- 持續的學習與調整:AI技術不斷演進,其決策能力也在變化。領導者必須保持對新技術的敏感度,並持續評估和調整AI在決策體系中的角色與權重,確保其始終服務於企業的長期利益與核心價值。

在AI決策迷霧中,領導者的清明與堅定是至關重要的。他們的角色並非被AI取代,而是昇華為更具智慧、更負責任的決策引導者,確保技術的進步始終以人為本,並為企業的永續發展奠定穩固的基石。

決策責任的不可外包性結論

總而言之,在AI浪潮席捲而來的時代,決策責任的不可外包性,是每一位領導者都必須深刻銘記的核心原則。AI技術的強大輔助能力,無疑為我們開啟了前所未有的決策視野,但這並不意味著我們可以將最終的判斷與後果,推諉給冰冷的演算法。領導者的價值,正是在於能夠駕馭這些智能工具,結合人性化的價值觀、深刻的洞察力以及對組織長遠發展的承擔,做出真正有智慧、有擔當的抉擇。

我們已經深入探討了AI輔助決策的本質,釐清了AI的角色應當是「輔助」而非「代理」,並強調了建立健全的AI治理框架、培養團隊的AI素養與批判性思維、以及堅守人本價值觀的重要性。唯有如此,我們才能確保AI技術真正服務於人類福祉,而非成為逃避責任的藉口。AI時代的領導力,更顯珍貴,它昇華為一種融合智慧、勇氣與道德的藝術,引導組織在複雜變局中穩健前行。

您的領導力,是AI時代最關鍵的把關者。 勇敢地面對AI帶來的機遇與挑戰,堅守決策的最後一道防線,這不僅是對您的企業負責,更是對未來負責。

若您正為如何有效運用AI技術、平衡創新與風險,並強化企業的品牌聲譽而苦惱,歡迎聯絡【雲祥網路橡皮擦團隊】。讓我們一同擦掉負面,擦亮品牌,在AI時代駕馭智能浪潮,開創更加光明燦爛的未來!

決策責任的不可外包性 常見問題快速FAQ

在AI時代,領導者的決策責任為何不可外包?

AI僅是輔助工具,無法真正理解情境、進行價值判斷或承擔後果,因此最終決策權與責任仍需由領導者承擔。

AI在決策過程中扮演什麼樣的角色?

AI主要扮演輔助角色,提供數據分析、風險評估與建議,以增強人類決策的廣度和深度,但不能取代領導者的最終判斷。

領導者應如何培養團隊的AI素養與批判性思維?

透過提升AI知識水平、鼓勵質疑與探討AI輸出、理解數據影響、情境化應用AI,以及持續學習與調適來達成。

建立AI協作決策框架時,應注意哪些關鍵點?

領導者需確立AI輔助與領導者決策的界線,培養團隊AI素養與批判性思維,並建立健全的AI治理與倫理框架。

AI決策存在哪些侷限性?

AI的決策基於訓練數據和演算法,可能複製數據偏見,且難以進行價值判斷、倫理考量,或處理複雜的人類情境。

領導者在AI輔助決策中應如何堅守倫理界線?

領導者應制定清晰的AI倫理準則,優先考量人權與公平性,定期進行倫理審計,並推動AI決策的透明化與可解釋性。

如何區分AI的「輔助決策」與「代理決策」?

輔助決策中,AI提供資訊供領導者參考,決策權仍在人類;代理決策則將決策權讓渡給AI,可能導致責任模糊與失控。

領導者在AI輔助決策中應扮演的最終把關角色是什麼?

領導者需具備辨識系統性風險的能力,堅守人本價值與倫理界線,建立問責機制,並持續學習與調整AI的角色,確保其符合企業長期利益與核心價值。